MK6 (4) – Computational Cities

Durane il quarto giorno di quello che potremmo chiamare MasterKeen juke-box, dopo la giornata di design con Gabriele Gallo e quella dedicata a intelligenza artificiale e machine learning, la strada ci ha portato ad affrontare una serie di temi che vanno dal Computational Design ai cosiddetti Big Data, passando per un paio di considerazioni che riguardano il rapporto […]

Durane il quarto giorno di quello che potremmo chiamare MasterKeen juke-box, dopo la giornata di design con Gabriele Gallo e quella dedicata a intelligenza artificiale e machine learning, la strada ci ha portato ad affrontare una serie di temi che vanno dal Computational Design ai cosiddetti Big Data, passando per un paio di considerazioni che riguardano il rapporto tra BIM, GIS e Smart Cities. Siamo rimasti a una scala più bassa rispetto al lavoro fatto sulle Smart Cities in dicembre, per cui rimando a quel materiale chi fosse interessato a cavalcare praterie più vaste.

Ancora influenzati dalla giornata di Data Analysis e Machine Learning, abbiamo aperto la giornata con tre presentazioni:

- Marco Falbo, dopo aver letto il ciclo della Fondazione di Asimov, ci ha parlato della Psicostoria;

- Marco Pascale, dopo aver giocato a Block’hood, ha parlato di Smart Cities con “UTOPIAlization”;

- Michele Fiaschi, dopo aver guardato La Città Incantata, ha parlato di “Fantasy BIM”.

La presentazione di Marco Pascale.

Le presentazioni sono state un’occasione per riflettere sull’importanza del dato, sulle dinamiche connesse dei nuovi edifici, sulle connessioni sociali e tencnologiche tra le figure chiavi della modellazione informativa. In particolare…

1. Dati e sostenibilità

In particolare, a margine dei temi di ecosostenibilità e sostenibilità sociale legati a Block’hood, consiglio anche il videogioco Oxigen Not Included, il gestionale di una stazione spaziale in cui le risorse principali sono acqua, calore, cibo e ossigeno, e Frostpunk, ormai leggendario gioco a metà tra il city builder e il survival. Riferimento obbligato è anche il lavoro dei francesi di R-urban, progettisti di sistemi per la resilienza urbana.

2. Le figure coinvolte nel processo BIM

Giocando con Michele Fiaschi sulle suggestioni organizzative tratte dalla Città Incantata (Sen to Chihiro no kamikakushi), è emersa l’occasione per una digressione circa i ruoli e le mansioni in ambito BIM.

Alcune slide dal contributo di Michele Fiaschi

In particolare, è evidente che il MasterKeen si fonda sulle figure così come imbastite durante i primi ragionamenti fatti con Angelo Ciribini riguardo alle figure necessarie per il BIM in Italia (figure intorno alle quali, con l’eccezione del CDE manager, ruotava anche il mio libro due anni fa), recentemente battezzate con l’uscita della norma UNI 11337-7.

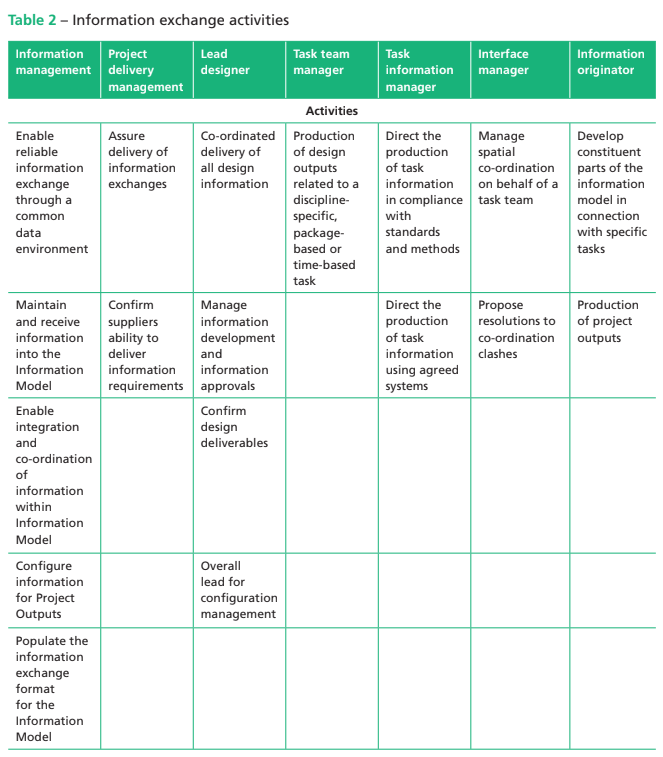

Non si tratta però dell’unico framework possibile e che esiste una pluralità di figure, codificate e non, con cui bisogna misurarsi: la cosa è evidente anche solo leggendo la PAS 1192-2 al capitolo riguardante i ruoli.

Tempo fa, sotto la guida di Alberto Pavan, l’allora tesista Emanuele Mollica ha sviluppato un lavoro estremamente estensivo mappando le varie figure del BIM così come appaiono in diverse fonti. La sua tesi è disponibile sul portale del Politecnico a questo indirizzo. Per accedere alla tesi bisogna purtroppo essere autorizzati all’accesso del portale, posso però condividere con voi uno degli schemi che corredavano le oltre 400 pagine del lavoro di Emanuele e consigliarvi di scrivere a lui (o al prof. Pavan) per il testo completo.

1. A scala urbana: generative e computational design

La trasmissione dei dati è certamente più semplice quando la progettazione è frutto di un pensiero computazionale. Sfortunatamente, e indipendentemente da quanto io possa considerare o meno fallimentare il tentativo di progettare top-down intere città, l’utilizzo di algoritmi per la progettazione di città è storicamente sfortunato e se volete sapere perché vi consiglio vivamente di leggere il libro di Anthony Townsend sulle Smart Cities.

La versione breve della storia ha a che vedere con la corsa allo spazio, l’IBM e una piccola cosa chiamata “Dinamica dei Sistemi”.

1.1 Dinamica dei Sistemi

Nel 1968, l’allora vicepresidente degli Stati Uniti H.H. Humphrey nel tentativo di giustificare il denaro speso dall’amministrazione per la ricerca spaziale dichiarava:

«Le tecniche che porteranno l’uomo sulla Luna

saranno le stesse

di cui avremo bisogno

per ripulire le nostre città».

Le dinamiche che riguardano i tentativi di applicazione delle ricerche spaziali ad altri ambiti, sono oggetto del capitolo 19 del libro illustrato Spacesuit: Fashioning Apollo, di Nicholas de Monchaux, intitolato “Cities and Cyborgs” (ma se siete interessati alla relazione tra la ricerca spaziale e i progressi tecnologici di cui ci occupiamo, vi consiglio anche Digital Apollo, di David A. Mindell, sempre edito da MIT Press)

La necessità di applicare sulla Terra le ricerche sviluppate per i programmi spaziali non è naturalmente un fenomeno limitato agli anni ‘60: lo stesso principio guida e giustifica ancora oggi le missioni spaziali di fronte all’opinione pubblica, come peraltro accade in altri campi di sperimentazione tecnologica come la Formula Uno.

Lo stesso James Webb dichiarava, durante il suo discorso di insediamento ad amministratore della NASA nel 1961:

«ci stiamo impegnando in ogni modo possibile a restituire ciò che impariamo alla totalità dell’economia nazionale».

È un problema etico e morale ragionevole che ha delle risposte razionali, in cui naturalmente non mi posso addentrare in questa sede. Se siete curiosi, i dibattiti on-line ìsono molteplici: state solo attenti ad esplorare fonti di qualità.

Tornando al periodo che ci interessa, all’alba dello sbarco sulla luna, uno dei primi tentativi di applicazione delle tecnologie NASA all’urbanistica è il coinvolgimento dell’Agenzia Spaziale da parte di Wayne Thompson, amministratore di Oakland, in California, e presidente dell’International City Managers’ Association. Thompson aveva iniziato la sua carriera a 27 anni come amministratore di Richmond, il più giovane nella storia americana, e poco dopo aver preso servizio ad Oakland invita 35 ufficiali e dirigenti della Space Agency per discutere punti di interesse comune e, in particolare, della possibilità di sfruttare le conoscenze maturate durante le missioni spaziali e di applicarle a problemi critici come l’aumento esponenziale della popolazione nelle aree urbane.

I risultati di questo tavolo comune vengono resi pubblici in una conferenza del 1963 chiamata “Space, Science, and Urban Life”, supportata non solo dalla NASA e dalla Città di Oakland ma anche dall’Università della California e dalla Fondazione Ford. Potete acquistare una copia degli atti su eBay, se vi sbrigate.

Si tratta di un momento cruciale per la storia dell’urbanistica, ma non nel senso che si potrebbe immaginare: l’incontro tra le tecniche di simulazione e la pianificazione della città sarà fatale in molti sensi. Durante gli incontri, vengono presentate tecniche innovative di indagine e modellazione algoritmica, non solo da James Webb e dalla NASA ma anche da luminari come Jerome Wiesner, che all’epoca era già presidente della commissione scientifica per l’aministrazione Kennedy, Martin Meyerson, presidente dell’Università della Pennsylvania, e Daniel Burnham, autore tra le altre cose del master plan per lo sviluppo di Chicago. Le discussioni nella conferenza affrontano temi che vanno dall’automazione alle biotecnologie, ma per quanto riguarda la modellazione e la simulazione, il gruppo è unanime nell’identificare come particolarmente promettente l’utilizzo della dinamica dei sistemi, una teoria che Jay Forrester stava sviluppando in seno al MIT.

Forrester aveva messo a punto parte della teoria chiamata dinamica dei sistemi lavorando allo sviluppo di SAGE, un sistema che collegava tra loro dozzine di bunker e stazioni radar attraverso il Nord America: la sua tecnica riguardava la modellazione matematica di sistemi industriali e il culmine del suo lavoro, Industrial Dynamics, viene pubblicato nel 1961. Entra al MIT nel 1956, come professore alla nuova Sloan School of Management, ma inizia a interessarsi alle città grazie all’incontro con John Frederick Collins, che era stato sindaco di Boston tra il 1960 e il 1968: i due mettono insieme un gruppo di ricerca con l’obiettivo di sviluppare in un sistema generale che potesse essere utilizzato per l’analisi e lo studio di tutte le città degli Stati Uniti. Il lavoro culmina con la pubblicazione di Urban Dynamics nel 1963, nello stesso anno della convention di Oakland.

Il libro è impostato come un caso studio: parte da una situazione di equilibrio stagnante considerata tipica delle città americane, con un alto tasso di disoccupazione, condizioni abitative scadenti e mancanza di alloggi adeguati per professionisti specializzati provenienti da fuori. A partire da questa situazione, il modello simula una serie di politiche sociali e raggiunge risultati che all’epoca vennero considerati anti-intuitivi: politiche di formazione per i disoccupati risultavano in un peggioramento della situazione e una delle conclusioni raggiunte dal sistema era la necessità di demolire i bassifondi per fare spazio a edifici di lusso, sia a scopo commerciale che residenziale. Il modello considerava controproducente l’edilizia residenziale pubblica, che risultava in un incentivo al ristagnare delle condizioni di povertà. Si trattava di conclusioni che si sarebbero rivelate corrette, soprattutto in relazione ad esperimenti come il disastroso progetto urbanistico Pruitt-Igoe per Saint Louis o, per distogliersi dall’urbanistica in senso stretto, esperimenti come il provvedimento Hartz IV della Germania socialista, che tragicamente sta venendo ripetuto in Italia con il cosiddetto “reddito di cittadinanza”.

Nonostante i suoi meriti, Urban Dynamics apre la strada a una lunga serie di fallimenti, principalmente derivati da un approccio semplicistico dei modellatori al “sistema città”. Particolarmente significativo, e con tragiche conseguenze, il modello sviluppato dal RAND Institute per il corpo dei vigili del fuoco di New York che, nel 1971, consigliò la chiusura di alcuni tra i principali punti di risposta nei quartieri più poveri. L’operazione è causa di alcuni tra i più tragici incendi nella storia della città ed è al centro dell’inchiesta di Joe Flood, The Fires: How a Computer Formula, Big Ideas, and the Best of Intentions Burned Down New York City–and Determined the Future of Cities.

New York City, 1968. The RAND Corporation had presented an alluring proposal to a city on the brink of economic collapse: Using RAND’s computer models, which had been successfully implemented in high-level military operations, the city could save millions of dollars by establishing more efficient public services.

La possibilità di affidarsi alla simulazione urbana tramite modelli viene simbolicamente seppellita da Douglass Lee nel suo articolo “Requiem for Large-Scale Urban Models”, pubblicato sul Journal of the American Institute of Planners nel maggio 1973. Lee individua quelli che chiama i “sette peccati” di questo tipo di modellazione:

- il tentativo di includere troppo nei modelli (hyper-comprehensiveness);

- l’eccessiva approssimazione dei dati modellati (grossness);

- un’aspettativa troppo alta riguardo alle capacità di deduzione del modello (hungriness): il modello per il mercato immobiliare di San Francisco aveva bisogno di 15.000 righe per ogni singola iterazione, senza considerare i dati necessari per la calibrazione preliminare, perché si ipotizzava di poterlo utilizzare per qualunque uso (non so se il concetto suona familiare);

- una deviazione tra il comportamento percepito del modello e le attuali regole che lo governano (wrongheadedness): ache in questo caso, un problema di mancata circoscrizione dell’uso ha portato a considerare questi modelli come specchi universali del comportamento delle città a ogni scala mentre, ad esempio, un modello potrebbe essere valido su scala urbana ma non attendibile sulla scala del quartiere a causa delle approssimazioni he opera;

- un’eccessiva sofisticatezza delle strutture dati e l’eccessivo numero di variabili (complicatedness);

- un problema di hardware inadatto ai calcoli richiesti (mechanicalness);

- l’eccessivo costo per la realizzazione di questi modelli (expensiveness).

Questi sistemi di modellazione vengono quindi accantonati e il loro utilizzo non segue il percorso che ci si sarebbe potuti attendere considerando i soli progressi fatti tra gli anni ’60 e gli anni ’70.

Non sarebbe tuttavia corretto dire che la dinamica dei sistemi venga abbandonata: viene utilizzata fino al primo decennio del XXII secolo e, ad esempio, la IBM ha recentemente lavorato a Portland su un modello chiamato System Dynamics for Smarter Cities, il cui principale merito è probabilmente l’introduzione di un sistema di interfaccia tra il modello matematico e l’utente finale, che sia urbanista o semplice cittadino, in cui è possibile non solo interrogare il modello ma modificare alcuni dei suoi assunti di base.

Intorno al 2010, la dinamica dei sistemi viene soppiantata da altre tecniche di modellazione. La principale si basa su un altro concetto, cruciale nelle scienze dell’informazione: il concetto di agente. Il design delle prime versioni di Sim City è mutuato direttamente da Urban Dynamics, ma nel 2013 il motore di simulazione viene sostituito da GlassBox, un motore di simulazione basato su agenti.

1.2 Parametric Design e Urban Planning

Il discorso si riapre, naturalmente, insieme alla diffusione della progettazione parametrica e del computational design. Per chi fosse interessato all’argomento, posso aggiungere ben poco all’ottimo articolo “Parametric Urbanism: A New Frontier for Smart Cities” firmato da Paolo Fusero, Lorenzo Massimiano, Arturo Tedeschi e Sara Lepid, pubblicato sul numero 27 di Planum e disponibile a questo indirizzo.

In only a few short years the concept of Smart Cities has evolved from an evocative representation of futuristic digital metropolises into an overblown term used to indicate all manner of virtuous processes: economic, environmental, technological, social, etc. It now appears that any human activity we wish to qualify in positive terms cannot avoid being tagged with the adjective “smart”.

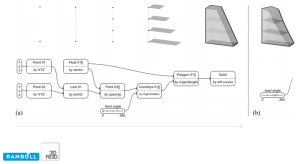

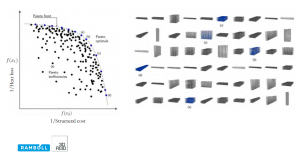

Una buona fonte di ulteriore approfondimento è il lavoro svolto da 3dreid in partnership con il dipartimento di computational design di Ramboll. Trovate qui la presentazione relativa alla ricerca.

Qualche pagina dalla presentazione di 3dreid + Ramboll: Parametric Massing for Effective City Design

“We can set up an algorithm to design the hull of a sailing boat,

with parameters for curvature and a fitness function of

minimising drag, but such an algorithm would never come up

with a catamaran.”

(Coates, 2010).

2. A media scala: l’insediamento

Scendendo di scala, e con l’aiuto di operazioni come il Generator di Cedric Price e il Perpetual Architect sviluppato da John e Julia Frazer, abbiamo analizzato le traversie di quello che abbiamo chiamato insediamento adattivo, ovvero la possibilità di sviluppare un layout che sia predisposto e governato da un algoritmo. Impossibile affrontare l’argomento senza passare anche per i lavori del collettivo Archigram.

A margine del discorso, ci siamo concessi un paio di piccole sfide: la costruzione di un sistema per il controllo della stazione di ricerca Halley VI e la costruzione di un algoritmo per il posizionamento e il controllo dei moduli di un insediamento per BIM specialist, sulla base della costruzione di personalità, dell’individuazione di attività chiave e della costruzione di una matrice di compatibilità non molto diversa da quella intorno alla quale ruotava il progetto di Cedric Price.

3. From Small Data to Big Data

Un ulteriore ragionamento, scendendo ulteriormente di scala e per non lasciare a metà il discorso, sarebbe da fare sulla migliore modalità per far sì che i modelli che produciamo, anche alla scala dell’edificio, siano in grado di trasmettere dati utili alla gestione del tessuto urbano.

Per chi non avesse familiarità con il Fascicolo del Fabbricato, si tratta di una controversa iniziativa la cui introduzione obbligatoria è stata tentata a più riprese: nel sui formato più diffuso, è una scheda di circa dieci pagine che dovrebbe contenere informazioni come l’epoca del fabbricato, la presenza o meno di superfetazioni e sopraelevazioni, le coordinate dimensionali, certificazioni di conformità ecc. Dovrebbe costituire il set minimo di informazioni necessarie per tenere sotto controllo lo stato di tutti gli immobili presenti sul territorio. Il fascicolo era stato individuato dal Rapporto sulla Promozione della sicurezza dai Rischi naturali del Patrimonio abitativo di Casa Italia come uno dei modi possibili per mappare il livello di rischio cui sono sottoposti gli immobili, in particolare a seguito degli ultimi eventi sismici nel centro Italia. Gli strumenti che venivano individuati, in particolare, erano:

- un intervento diffuso di diagnostica speditiva, con oneri a carico dello Stato, nelle aree ad elevato rischio sismico;

- la redazione del fascicolo del fabbricato;

- l’implementazione di un Repository unico delle informazioni sui fabbricati che raccolga le informazioni già presenti negli archivi delle amministrazioni pubbliche.

Già nell’ottobre 2017 ad un convegno Ance però, il capo dipartimento di Casa Italia della Presidenza del Consiglio Roberto Giovanni Marino si era espresso senza mezzi termini dichiarando la propria preferenza per la terza soluzione: il fascicolo è controverso perché affidato alle amministrazioni dei singoli immobili, mentre la redazione del repository unico sarebbe a onere dello Stato. Dall’altro, anche solo sfogliando un fascicolo di esempio è evidente che le informazioni da esso richieste, per quanto forse già in possesso di organi come il catasto, non solo non sono mappate in un database ma spesso non sono nemmeno digitalizzate.

Al momento, provvedimenti come il Disegno di Legge n. 3032 (29 novembre 2011) e la Legge Regionale n. 31 del Lazio (dell’anno successivo) demandano ai singoli comuni la possibilità di introdurre un’obbligatorietà del fascicolo del fabbricato. Il disegno di legge ci fornisce anche una buona descrizione di ciò che dovrebbe contenere il fascicolo:

Il Fascicolo del Fabbricato (Art. 1) deve essere redatto da un tecnico abilitato,

aggiornato con cadenza non superiore a 10 anni,

e tenuto a cura del proprietario o dell’amministratore del condominio.

Sul fascicolo vanno annotate le informazioni relative all’edificio di tipo identificativo, progettuale, strutturale, impiantistico, ambientale, con l’obiettivo di pervenire ad un idoneo quadro conoscitivo a partire, ove possibile, dalle fasi di costruzione dello stesso.

Vanno inoltre registrate le modifiche apportate rispetto alla configurazione originaria, con particolare riferimento alle componenti statiche, funzionali e impiantistiche.

Le motivazioni che portano il rapporto a considerare inefficiente il fascicolo del fabbricato in sé vengono evidenziate nel rapporto come:

- I dati coprono solo parzialmente, e in modo talvolta disomogeneo, il territorio nazionale;

- Le anagrafiche degli edifici non sono omogenee nei diversi archivi;

- I diversi archivi non sono oggi interoperabili.

La soluzione proposta sarebbe quindi la realizzazione di un sistema, ospitato dall’Agenzia delle Entrate, che bypassi la realizzazione dei fascicoli e demandi alle amministrazioni pubbliche la raccolta e l’inserimento delle informazioni.

Senza volermi necessariamente schierare per una fazione rispetto all’altra, e riconoscendo gli evidenti motivi di interesse personale che spingono le associazioni professionali a questa posizione, il Consiglio Nazionale degli Ingegneri si è espresso schierandosi in favore del fascicolo, a partire dal quale realizzare il repository centrale di cui parla Casa Italia. Per far questo, sarebbero necessari due passaggi che possono essere svolti in parallelo:

- la creazione di un template di fascicolo, unico per ogni regione;

- la creazione del repository in cui far confluire i campi di ogni scheda;

- la compilazione dei fascicoli sul territorio;

- l’acquisizione dei fascicoli compilati all’interno del repository.

La creazione di un database che raccolta le informazioni contenute in una scheda è un’operazione tecnicamente elementare. Sono la creazione del template e la sua compilazione a essere la parte stimolante di questa soluzione.

Non è certamente compito nostro creare un template di fascicolo: avremmo bisogno di competenze che non sono al nostro tavolo. Quello che però possiamo fare è, a partire da un fascicolo esistente, proporre una mappatura dei campi di un modello BIM (rvt con controllo di conformità in ifc, per cominciare) in modo che sia possibile estrarre le informazioni dal gemello digitale dell’edificio, senza compilazioni manuali e senza ridondanze.

2 Comments